Økt forretningsverdi med riktig databruk og AI

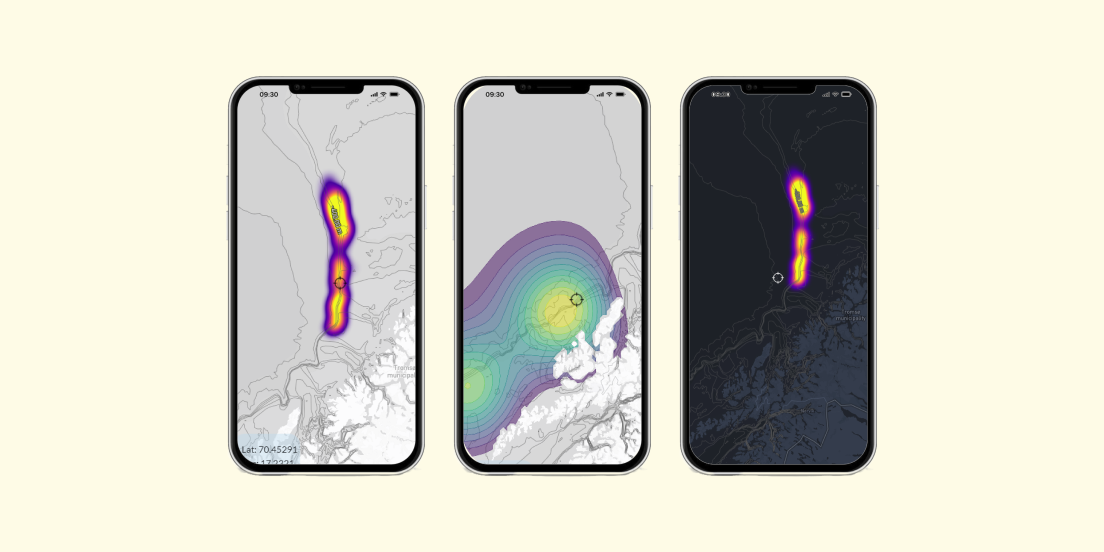

Hos Knowit finner du et av Norges fremste fagmiljøer innen kunstig intelligens. Vi kombinerer innsikt, kompetanse og praktiske systemer for å skreddersy brukervennlige løsninger som lar deg bruke AI-tjenester til din fordel.

Dette kan vi hjelpe deg med

Slik sikrer du virksomhetens fremtid med KI, innsikt og riktig dataplattform

Skreddersydde løsninger som kombinerer kunstig intelligens (AI), innsikt og dataanalyse er nøkkelen til suksess i fremtiden. Med Knowit som teknologipartner får du ikke bare innovative og pålitelige systemer, men også en strategi som sikrer virksomhetens vekst og konkurransekraft, uansett dataplattform.

Les mer om hvordan vi kan hjelpe deg her

Etter å ha vurdert innkomne tilbud etter oppgitte tildelingskriterier, kan vi meddele at vi ha som intensjon å tildele kontrakten til Knowit med følgende begrunnelse: Knowit er den leverandøren med sterkest kompetanse og erfaring innen metode og prosesser for Generativ AI.

VY valgte Knowit på innføring av Copilot for Microsoft, September 2024

Vy

Her finner du noen av våre referanser

Vi samarbeider med ledende partnere

Sammen med verdensledende forretningspartnere og samarbeidspartnere utvikler vi unike og bærekraftige digitale løsninger som styrker våre kunders forretningsfordeler.

KI-forordningen er vedtatt: Vår sjekkliste til deg som leder

I dette blogginnlegget gir vi deg en praktisk sjekkliste og konkrete tiltak som hjelper deg å navigere i KI-regelverket og sikre at din virksomhet er godt forberedt på fremtidens krav.

Nye idéer og raskere analyse med Gemini i BigQuery

For mange har det blitt en vane å chatte med store språkmodeller som ChatGPT, Copilot, My AI, Gemini eller lignende, både i jobbsammenheng og privat. Men kan man snakke med sin egen data for å få mer innsikt? Med Gemini i BigQuery får du en tryggere og mer effektiv løsning for håndtering av sensitiv data, spesialisert for utfordringer knyttet til Google Cloud.

Hvordan AI kan akselerere arbeidet med bærekraft og sirkulærøkonomi

I en verden hvor bærekraft og økonomisk vekst har blitt sett på som motstridende krefter, kan AI gi oss muligheten til å forene disse to. Med den stadig økende integrasjonen av AI i vårt daglige liv, ser vi nå hvordan denne teknologien kan være en katalysator for sirkulærøkonomien.

Christian Martinsen

Kommersiell direktør

Knowit Norge